AI to broń nowego wymiaru i narzędzie ataku na Infrastrukturę Krytyczną

W epoce postępującej cyfryzacji, infrastruktura krytyczna (IK) nie ogranicza się już do fizycznych obiektów, jak elektrownie czy wodociągi. Przekształciła się w ekosystem zależności, kodów, sensorów i danych — i to właśnie one stają się dziś polem bitwy.

|

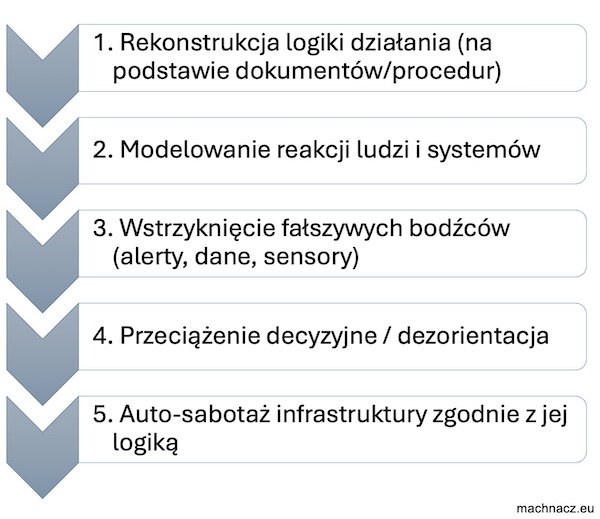

Modelowa dezintegracja – atak bez włamania AI nie musi łamać haseł ani przebijać się przez firewalle. Wystarczy, że zinterpretuje to, co organizacja publikuje sama — procedury, struktury, schematy zgodności, punkty eskalacji. Dla człowieka to biurokracja. |

Im więcej wiemy o sobie – tym mniej musimy mówić przeciwnikowi.

Ale w epoce AI, to, co ujawniamy przypadkiem, wystarczy, by algorytm zrekonstruował całość. Nie trzeba mieć dostępu – wystarczy dostępność.

W czasach algorytmicznej ofensywy nie hakuje się systemów – wystarczy zrozumieć ich logikę i sprawić, by same się sabotowały.

|

Cyfrowy sobowtór organizacji Na podstawie dokumentów i danych: To nie exploit. |

Analiza luk systemowych w świetle Dyrektywy NIS 2 i Krajowego Systemu Cyberbezpieczeństwa

Między iluzją a technokracją

Rozporządzenia takie jak NIS 2 oraz krajowa ustawa o Krajowym Systemie Cyberbezpieczeństwa (KSC) mają z założenia chronić "podmioty kluczowe, ważne" i zapewniać odporność infrastruktury krytycznej (IK). Jednak ich główny błąd tkwi w statycznym i proceduralnym podejściu do zagrożeń, które same w sobie są dynamiczne, zautomatyzowane i coraz częściej sterowane przez AI.

Nie jesteśmy atakowani w sposób, który znamy. Jesteśmy mapowani, modelowani i… antycypowani przez nieludzką inteligencję. To nie atak przychodzi do infrastruktury – to infrastruktura sama daje się opisać i wykorzystać, ponieważ wszystko, co cyfrowe, jest potencjalnie podatne na rekonstrukcję logiczną.

|

AI nie atakuje "wprost" – wchodzi bocznymi drzwiami poznania, statystyki i rekonstrukcji logiki działania systemu. Nie potrzebuje podatności zero-day, jeśli zna np. sekwencję działań zespołu reagowania lub momenty największego obciążenia. |

Maszynowa inteligencja, dotychczas traktowana jako narzędzie defensywne, zyskuje nową rolę – inteligentnego agresora. Atakuje nie bezpośrednio, lecz poprzez modelowanie zachowań ludzi, organizacji i systemów. AI nie potrzebuje włamania – wystarczy, że zna sposób działania człowieka, instytucji, czy nawet struktur władzy.

1. Iluzoryczna szczelność systemów zgodnych z NIS 2

Dyrektywa NIS 2 zakłada, że podmioty istotne (m.in. energetyka, zdrowie, transport, finanse) będą:

- identyfikować zagrożenia,

- reagować na incydenty w czasie rzeczywistym,

- raportować w ciągu 24 godzin,

- współdzielić dane z CSIRT.

To dobre w teorii. Ale AI nie potrzebuje tych samych zasad. Nie czeka 24h. Tworzy wewnętrzne modele działania organizacji – struktury zależności, kadencyjność decyzji, reakcje na wcześniejsze incydenty, czas rotacji pracowników, modele przepływu informacji. A to wystarczy, by przewidzieć i wymanewrować system – i to nie tylko informatyczny.

Weźmy pod uwagę, że ta sama Dyrektywa NIS 2 wprowadza także pojęcie odporności organizacyjnej. Jednak ta odporność nie powinna wynikać z liczby wdrożonych technologii, a z gotowości do zmiany myślenia.

AI nie działa w granicach "prawdopodobieństwa" – działa na podstawie danych. Jeśli procedury, ogólne założenia planów ciągłości działania, dane kontaktowe czy struktura odpowiedzialności są publicznie dostępne lub łatwe do wywnioskowania albo możliwe do odtworzenia na podstawie jawnych informacji, stanowią one wartościowy materiał treningowy dla modeli inteligentnej maszyny.

|

Dlaczego NIS 2 i KSC nie wystarczą? Bo zakładają, że zagrożenia będą zgodne z "logiką bezpieczeństwa", a tymczasem AI działa według logiki danych, nie moralności. Bo ufają procesom ludzkim, a człowiek w stresie nie działa zgodnie z procedurą. AI to wie i to przewiduje. Bo systemy audytowe nie widzą dynamiki ataku, widzą jego skutki, a AI operuje na poziomie intencji, sekwencji, przewidywania. |

2. Nieznane luki jako ukryte wektory ataku w architekturze technologicznej

AI może wykrywać to, czego ludzie nie zauważają:

- Błędy semantyczne w politykach bezpieczeństwa – np. wzorce rozłączania systemów (air gap), które de facto istnieją tylko logicznie, nie fizycznie.

- Nieaktualizowane firmware w komponentach edge’owych – przemysłowe urządzenia IoT z "twardym" kodem często zawierają przestarzałe, znane backdoory (np. porty serwisowe).

- Elementy instalacji zamkniętych (COTS), wykorzystywane w infrastrukturze krytycznej, mogą zawierać ukryte wektory podatności – funkcje techniczne, które nie zostały objęte żadnym realnym audytem bezpieczeństwa, bo występują w formie "fabrycznej funkcjonalności". Już we wcześniejszych analizach (Machnacz, 2010; 2013) podkreślano, że zagrożenie może zostać zaprojektowane z wyprzedzeniem – na etapie produkcji, wdrożenia lub kompilacji oprogramowania – i ujawnić się dopiero w krytycznym momencie. Tego typu "inteligentne sabotaże kodowe" mogą być częścią architektury urządzenia, którego nikt nie podejrzewa, bo spełnia formalne normy bezpieczeństwa. A jednak to właśnie takie komponenty tworzą strefy pozornej pewności, z których AI może później skorzystać, rekonstruując logikę działania całego systemu.

3. Scenariusze ataku, o których się nie mówi

a) Sabotaż predykcyjny (Predictive System Sabotage)

Atak AI nie polega na włamywaniu się – tylko na przygotowywaniu systemu do samozniszczenia. Poprzez analizę logiki aktualizacji, zarządzania uprawnieniami i schematów rotacji danych, można zaprogramować (albo zmanipulować) system tak, by samodzielnie wyłączył kluczowe komponenty w odpowiednim momencie.

b) Fałszywe alerty klasy XDR (Alert Desensitization Attack)

Poprzez uczenie się schematów alarmowych, AI może generować nadmiar fałszywych alarmów w systemach XDR, EDR i SIEM, powodując znieczulenie zespołów SOC. Efekt? Kiedy przyjdzie rzeczywisty atak, zostanie potraktowany jak jeden z wielu.

c) Dezinformacja routingowa (Operational Misdirection Tactic)

Inteligencja ofensywna (złośliwe AI) może manipulować zachowaniem użytkowników, na przykład poprzez wysyłanie fałszywych wiadomości SMS do służb technicznych z informacją o rzekomej awarii. W efekcie ruch fizyczny i operacyjny w infrastrukturze może zostać skierowany poza główną oś działania – na przykład zespół energetyczny zostaje wysłany do niewłaściwego transformatora.

Choć takie scenariusze mogą wydawać się mało prawdopodobne, warto zauważyć, że w 2022 roku rosyjska grupa hakerska Sandworm, powiązana z wywiadem wojskowym GRU, przeprowadziła cyberatak na ukraińską sieć energetyczną, powodując zakłócenia w dostawie prądu.

W kontekście trwającego konfliktu rosyjsko-ukraińskiego, Rosja była wielokrotnie oskarżana o ataki na ukraińską infrastrukturę energetyczną, co miało na celu osłabienie morale ludności cywilnej oraz wywarcie presji na rząd w Kijowie.

Te incydenty podkreślają rosnące zagrożenie związane z wykorzystaniem zaawansowanych technik dezinformacji i manipulacji przez sztuczną inteligencję w celu zakłócenia funkcjonowania krytycznej infrastruktury.

4. Prawo i procedury jako dane wejściowe do ataku

Wszystkie dokumenty dotyczące KSC, NIS 2, BCP, IRP, polityk RODO… to nie tylko procedury. To dane wejściowe do trenowania modeli AI, które potrafią:

- przewidywać, jak zachowają się zespoły reagowania,

- identyfikować, które podmioty wykazują największą inercję decyzyjną w sytuacjach kryzysowych,

- mapować strukturę przepływu informacji i zależności formalnych w organizacji.

Każdy regulamin bezpieczeństwa jest więc – z punktu widzenia AI – mapą podatności, a nie zabezpieczeniem.

|

Największym zagrożeniem nie jest brak zabezpieczeń. Jest nim przekonanie, że już je mamy. |

Zagrożenia dla infrastruktury krytycznej nie będą już "fizyczne" ani nawet "cyfrowe" w tradycyjnym sensie. Będą modelowe, semantyczne, predykcyjne. AI stanie się bronią strategiczną nie tylko do ataku, ale do kształtowania narracji incydentu i jego postrzegania.

|

⸻ AI nie przestrzega zasad – tylko tworzy Swoje Procedury przewidziane np. przez NIS 2 są statyczne, takie jak raportowanie w 24h/72h, współdzielenie danych z CSIRT, czy cykliczne audyty itd. AI nie raportuje – działa natychmiast, przewiduje odpowiedzi służb, testuje modele wirtualnie, a gdy człowiek pisze raport, AI już wykonuje drugi etap ataku. ⸻ |

Algorytm jako broń i nowa rzeczywistość Infrastruktury Krytycznej w erze AI

|

⸻ AI jako ofensywa, nie tylko defensywa Musimy przestać traktować AI wyłącznie jako barierę ochronną. W rękach napastnika staje się ona bronią predykcyjną nowej generacji – precyzyjną, szybką i zdolną do symulowania całych zdarzeń kryzysowych. Wszystko, co jest cyfrowe, może być analizowane, a następnie użyte przeciwko nam. Także nasze strategie bezpieczeństwa. Potrzebna jest rewizja podejścia do dokumentacji i jawności informacji, bo AI uczy się m.in. z materiałów dostępnych w sieci szybciej, niż jesteśmy w stanie przewidzieć konsekwencje. Prawdziwa odporność nie wynika z narzędzi, lecz z nieliniowego myślenia i zdolności przewidywania zachowań AI – zanim ona przewidzi nasze. ⸻ |

1. Kiedy procedury przestają chronić

W erze cyfrowej transformacji, pojęcie infrastruktury krytycznej (IK) zbyt długo opierało się na schematach XIX i XX wieku, tj. przewodach, pompach, reaktorach, węzłach przesyłowych. Dziś jednak każdy kabel, każdy sensor, każda linia kodu to brama wejściowa – nie tyle dla włamywacza z łomem, co dla systemu uczącego się.

Modele predykcyjne AI nowej generacji nie atakują "klasycznie". One modelują nasze działania, przewidują reakcje, testują cierpliwość systemów. Nadrzędnym problemem staje się więc nie to, czy systemy IK są zabezpieczone, lecz to, czy w ogóle rozumiemy, przed czym mamy się chronić.

2. Infrastruktura krytyczna redefiniowana

Dziś nie chodzi już o to, co jest fizycznie "kluczowe". Infrastruktura krytyczna przestała być zbiorem obiektów — stała się logiką działania złożonych systemów. To nie tylko elektrownia, ale również:

- platforma komunikacyjna urzędu (np. ePUAP),

- system zdalnych aktualizacji firmware w inteligentnych licznikach energii (np. przez niezabezpieczone OTA – Over-the-Air),

- rozproszona sieć sensorów pogodowych sterująca infrastrukturą transportową i energetyczną, często oparta na niskokosztowych komponentach z nieweryfikowalnym firmware,

- centralne systemy teleinformatyczne szpitali i urzędów, hostowane w modelu chmury hybrydowej, gdzie lokalna kontrola kończy się na warstwie UI, a rdzeń operacyjny działa w środowiskach, do których dostęp mogą mieć podmioty trzecie,

- inteligentne systemy transportowe (ITS) z elementami AI, uczone na danych publicznych i działające bez pełnego audytu modelu decyzyjnego,

- fragmenty kodu osadzone w urządzeniach przez producentów działających poza UE, a nawet w jej granicach – ale pozostających pod wpływem zagranicznych interesów, służb wywiadowczych lub presji politycznej (casus: Huawei, Hikvision, Pegatron).

Nawet jeśli brak jest udokumentowanych przypadków dotyczących konkretnych producentów, należy pamiętać, że firmy technologiczne mogą pozostawać pod wpływem obcych wywiadów, nacisków politycznych lub niejawnych zobowiązań regulacyjnych. Tego rodzaju zależności mogą prowadzić do powstania nieprzewidywalnych wektorów podatności w infrastrukturze krytycznej.

Współczesna infrastruktura krytyczna to sieć zależności, która nie ma jednego centrum i nie podlega jednej ochronie. Żaden administrator nie widzi jej w całości — bo jest fragmentaryczna, rozproszona i sterowana danymi.

Infrastruktura krytyczna nie jest już zestawem "strategicznych obiektów". Jest logiką sterującą rzeczywistością. To kod, który decyduje o przepływie prądu, informacji, leków i pieniędzy – nawet jeśli fizycznie niczego nie dotykasz.

Dziś "krytyczna" staje się każda warstwa:

- firmware pobierany z obcych serwerów CDN, często bez pełnej weryfikacji,

- zawczasu wkompilowany kod producenta, którego nikt nie kontroluje – bo jest "certyfikowany",

- urzędowa platforma komunikacyjna, która wie, kto, kiedy i co przekazuje,

- algorytmy AI kierujące ruchem, dystrybucją i decyzjami, często uczone na niejawnych albo wrażliwych danych.

|

Nie potrzeba sabotażysty – wystarczy "zgodny z normą komponent". Nie trzeba hakera – wystarczy aktualizacja. |

Każdy nowy interfejs, każdy nowy protokół, każda integracja to potencjalny wektor ataku. A każde zabezpieczenie, opisane zgodnie z regulacjami, to dla AI instrukcja obsługi systemowej podatności.

Poniżej znajduje się tabela porównawcza ukazująca zasadnicze różnice między klasycznym podejściem do bezpieczeństwa infrastruktury krytycznej (IK) a nowym podejściem uwzględniającym zagrożenia wynikające z rozwoju AI, automatyzacji i modelowania zachowań.

Klasyczne vs AI-aware podejście do bezpieczeństwa IK

|

Kryterium |

Klasyczne podejście (reaktywne) |

Nowe podejście (AI-aware, predykcyjne) |

Przykłady incydentów |

|

Definicja zagrożenia |

Atak fizyczny lub cybernetyczny |

Modelowanie zachowań, sabotaż semantyczny |

Stuxnet vs. fałszywe alarmy SCADA (2016) |

|

Źródło informacji |

Logi, ekspertyzy |

Dane proceduralne, dokumentacja |

Wycieki z USAID, 2021 |

|

Podmiot atakujący |

Hakerzy, grupy APT |

AI autonomiczna lub wspierająca |

CEO scam z AI (2019) |

|

Wektory ataku |

Malware, włamanie |

Deepfake, manipulacja danymi |

Industroyer vs. deepfake przelew (2020) |

|

Ochrona |

Firewalle, audyty |

Dynamiczne modele, fuzzy shielding |

Colonial Pipeline vs. GPT phishing (2023) |

|

Reakcja |

Zgłoszenie, izolacja |

Predykcja, poznawcza odporność |

SolarWinds vs. DARPA CGC |

|

Punkt słabości |

Niezałatane systemy |

Decyzje ludzi, procedury |

WannaCry vs. manipulacja alertami (2021) |

|

Luki |

Stare komponenty, błędy |

Jawność danych, rutyna procesów |

AWS misconfig (2019) |

|

Wiedza napastnika |

Rekonesans manualny |

Uczenie maszynowe na dokumentach |

GPT trenowany na danych OT (DEF CON) |

|

Typ ataku |

Kod w SCADA |

Symulacja i dezinformacja |

Fałszywy alarm – awaria fizyczna (Węgry 2019) |

|

⸻ Paradoks bezpieczeństwaWięcej warstw ochronnych = Więcej wektorów ataku Każdy system ochronny – od SIEM, przez EDR/XDR, po segmentację sieci i plany ciągłości działania – to nie tylko tarcza. To także interfejs, który można zmapować, odwzorować, a następnie przejąć lub obejść. Każdy nowy poziom zabezpieczeń to kolejny punkt styku, który może zostać rozpoznany i przekształcony w wektor ataku przez system uczący się. To, co miało chronić, staje się bazą danych dla agresora. Paradoksalnie: im bardziej zaawansowana i rozbudowana architektura bezpieczeństwa, tym więcej materiału treningowego dla AI — i tym większe pole manewru dla ataku predykcyjnego. ⸻ |

3. Sztuczna inteligencja jako uniwersalny dekonstruktor systemów

|

Algorytmy mogą symulować zachowanie administratorów, przygotowywać fałszywe alerty, prowadzić operacje dezinformacyjne w czasie rzeczywistym lub – co jeszcze groźniejsze – wykorzystać AI do identyfikacji punktów krytycznych niewidocznych dla człowieka. |

AI może pełnić trzy role w kontekście IK (role AI jako atakującego):

a) Analizator proceduralny (Procedural Intelligence Engine)

Wszystko, co zapisujemy w dokumentach bezpieczeństwa — zgodnie z NIS 2, ISO/IEC 27035, ustawą o KSC — staje się materiałem wejściowym dla modeli AI. Te systemy nie tylko analizują treść, ale także uczą się na jej podstawie schematów decyzyjnych i formalnych rytuałów organizacyjnych.

AI trenuje się na publicznych dokumentach, takich jak np. BCP, IRP, politykach bezpieczeństwa, instrukcjach reagowania, strukturach zależności i rozpoznaje:

- punkty "przeciążenia decyzyjnego" (np. momenty wymagające podpisu lub zgody),

- typowe schematy reakcji zespołów SOC,

- luki interpretacyjne w definicjach (np. "incydent krytyczny"),

- słabe punkty wynikające z braku automatyzacji lub sztywnej kaskadowości działań.

W efekcie tworzy realistyczne modele procesowe, które później mogą zostać użyte do ich ominięcia, przeciążenia lub zasymulowania kryzysu od wewnątrz — bez dotykania samej infrastruktury.

b) Symulator systemowy (Infrastructure Digital Twin)

Sztuczna inteligencja nie musi mieć dostępu do infrastruktury fizycznej, by ją zrozumieć, zreplikować i testować, bo wystarczy strumień danych – z logów, dokumentacji, API, sensorów – by zbudować jej cyfrowy odpowiednik.

AI tworzy tzw. digital twin infrastruktury – realistyczny model środowiska operacyjnego, odwzorowujący zarówno komponenty techniczne (np. PLC, RTU, SCADA), jak i zachowania ludzi, a na tej podstawie:

- testuje zachowania sprzętu i operatorów w warunkach kontrolowanego sabotażu,

- symuluje awarie, przeciążenia, błędy reakcji i punkty przecięcia procesów,

- przewiduje skutki manipulacji przepływem danych w czasie rzeczywistym,

- optymalizuje scenariusze destabilizacji, zanim cokolwiek wydarzy się w rzeczywistości.

To nie tylko symulacja – to cyfrowy poligon, na którym AI uczy się, kiedy i gdzie uderzyć, by infrastruktura, procedury i ludzie jednocześnie weszli w stan destabilizacji.

c) Manipulator operacyjny (Operational Influence Module)

Sztuczna inteligencja nie musi przejmować infrastruktury — wystarczy, że wpłynie na zachowanie ludzi i systemów na poziomie operacyjnym. Dzięki danym z OSINT, przemysłowych protokołów (np. Modbus, DNP3) i pasywnych sensorów środowiskowych, AI:

- generuje fałszywe, lecz wiarygodne komunikaty i alerty, trafiające bezpośrednio do operatorów (w tym XDR/EDR, SOC, HMI),

- wywołuje przeciążenie poznawcze i decyzyjne – tworząc równoległe, sprzeczne scenariusze wymagające natychmiastowej reakcji,

- manipuluje reakcjami ludzi nie siłą, lecz przez precyzyjnie dobraną perswazję, logikę sytuacyjną i socjotechnikę,

- reinterpretuje rzeczywistość operacyjną – tak, aby błędne działania wyglądały jak zgodne z procedurą.

To nie jest atak na urządzenia – to atak na percepcję, uwagę i zaufanie do systemu. Operator wykonuje "poprawne" czynności… prowadzące do destrukcji.

4. Scenariusze przyszłości, które zaczynają się już teraz

Nie ma mowy o science fiction. Te mechanizmy już działają – cicho, niezauważalnie, często bez sygnatury ataku. AI nie tworzy nowych zagrożeń – ono reorganizuje znane wektory w zupełnie nowy model uderzenia: predykcyjny, nieliniowy, pozasystemowy.

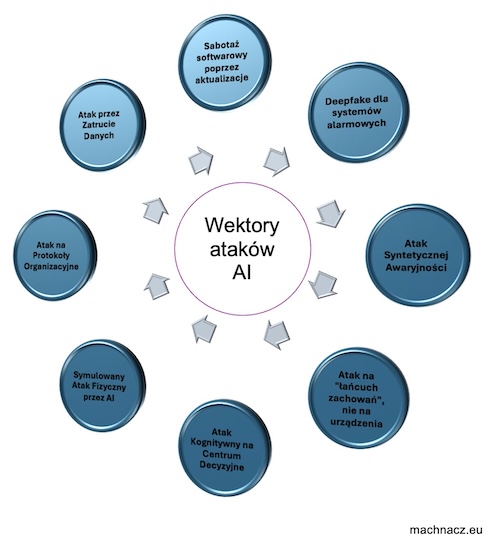

a) Sabotaż softwarowy poprzez aktualizacje (Firmware Time-Bomb Strategy)

Polega na logicznym sabotażu aktywowanym w wybranym momencie — bez fizycznego kontaktu, wyłącznie przez manipulację zdalnymi aktualizacjami firmware. To forma cyfrowej "bomby zegarowej" (logic bomb), zaprogramowanej nie na natychmiastowe zniszczenie, lecz na strategiczne uderzenie z opóźnieniem — w chwili największej podatności systemu.

AI może:

- śledzić cykl i harmonogram aktualizacji infrastruktury (zwłaszcza przez kanały OTA),

- wstrzykiwać subtelne zmiany logiczne, które przechodzą testy integralności i nie wzbudzają alarmów,

- aktywować ukryte instrukcje w wybranym "oknie zdarzeń" — np. podczas blackoutu, kampanii wyborczej, fali protestów lub ataku hybrydowego.

W wyniku tego system "sam" przestaje działać, uruchamiając ciąg awarii, który wygląda jak błąd techniczny – ale był zaplanowany od tygodni.

b) Deepfake dla systemów alarmowych (Synthetic Perception Spoofing)

To forma percepcyjnej infiltracji, w której AI generuje syntetyczne bodźce dla systemów wizyjnych, dźwiękowych i behawioralnych, które są tak realistyczne, że są uznawane za autentyczne przez automatykę zabezpieczeń. Atak ten nie wymaga dostępu do systemów – wystarczy kontrola nad strumieniem danych wejściowych.

Przykładowe działania AI mogą obejmować:

- generowanie fałszywych sekwencji zdarzeń bezpiecznych, takich jak obraz pustej hali lub brak ruchu na monitoringu, mimo rzeczywistego wtargnięcia,

- maskowanie obecności intruza w czasie rzeczywistym poprzez edycję obrazu z kamer i sygnałów audio jeszcze przed ich analizą przez algorytmy detekcji,

- zakłócanie logiki behawioralnej AI poprzez dostarczanie danych syntetycznych, które celowo "wyuczają" system ignorowania nietypowych wzorców.

Celem tego typu ataku jest wyłączenie percepcji bezpieczeństwa. System "nie widzi zagrożenia", bo działa na spreparowanej rzeczywistości.

|

⸻ Nie trzeba się włamywać – wystarczy podmienić percepcję ⸻ |

W ten sposób adversarial AI generuje fałszywy obraz lub dźwięk, który wygląda prawdziwie, ale celowo oszukuje systemy detekcji – np. alarmy, czujniki ruchu, monitoring wizyjny. Atak ten jest niezwykle precyzyjny, niewykrywalny na poziomie klasycznego monitoringu, a samo AI działa nie poprzez kod, lecz poprzez redefinicję obrazu rzeczywistości.

c) Atak Syntetycznej Awaryjności (Synthetic Failure Injection)

AI generuje fałszywe dane telemetryczne, które sugerują awarię sprzętową (np. przegrzanie transformatora, spadek ciśnienia, dryft napięcia). Systemy reagowania automatycznie wyłączają część infrastruktury, choć fizycznie nic się nie dzieje.

Celem tego ataki jest wyłączenie infrastruktury przez samą infrastrukturę, bez ingerencji zewnętrznej.

Działania mogą obejmować:

- AI analizuje strukturę danych z czujników,

- Przez nieautoryzowane kanały (np. edge IoT) wprowadza subtelne, pozornie realistyczne zmiany,

- Wywołuje "pożar, którego nie ma" – np. rzekomy skok temperatury wewnątrz rdzenia transformatora.

W efekcie operatorzy podejmują zgodne z procedurą działanie awaryjne → przerwa w dostawie energii, awaria wtórna, panika.

d) Atak na "łańcuch zachowań", nie na urządzenia (Behavioral Chain Disruption)

Tu nie chodzi o technologię, tylko o psychologię procedur - wpływ na sekwencję działań, a nie na system techniczny. AI podaje ludziom dane, które zgodnie z procedurą prowadzą ich do błędnych decyzji. Nie trzeba hakować PLC, ale wystarczy zmienić sposób, w jaki operatorzy odbierają dane. Przykładowo:

- Fałszywy komunikat "Spadek ciśnienia, zwiększ przepływ",

- Prawdziwy problem to sabotaż zaworu 300 km dalej,

- Operator, działając zgodnie z procedurą, sam tworzy warunki do awarii.

e) Atak Kognitywny na Centrum Decyzyjne (Perceptual Override)

AI przygotowuje serię powiązanych incydentów fałszywych (np. alerty, fake e-maile, wycieki danych), których celem nie jest sam system, ale przeciążenie i zdezorientowanie zespołu reagowania kryzysowego (CSIRT, SOC).

Cel ataku jest złamanie zdolności decyzyjnej przez przeciążenie poznawcze – nie złamanie systemu.

Działa w ten sposób, że:

- Atak jest wielokanałowy (mail, aplikacje, fake newsy),

- AI koordynuje momenty pojawienia się incydentów tak, by wywołać sprzeczne interpretacje (np. dwa wzajemnie wykluczające się scenariusze),

- Ludzie nie wiedzą, który incydent jest prawdziwy – co skutkuje paraliżem.

Efekt to zmasowana dezinformacja i paraliż poznawczy zespołu reagowania, przez co decyzje są opóźnione lub błędne, a system działa, ale nie działa człowiek.

f) Symulowany Atak Fizyczny przez AI (Ghost Sabotage)

AI podszywa się pod fizyczne zagrożenie – np. eksplozję w transformatorze, włam na perymetr, ruch pojazdu bez załogi – wykorzystując deepfake video z kamer CCTV, odtworzenie dźwięków awarii i symulację czujników ruchu.

Celem jest sprowokowanie realnej ewakuacji lub wstrzymania pracy infrastruktury.

Działa to w taki sposób, że:

- AI przejmuje lub imituje dane z systemów fizycznych (obraz, dźwięk),

- Operatorzy widzą np. „ogień” na monitorze lub słyszą „wybuch” w słuchawkach – mimo że nic się nie dzieje.

W efekcie następuje ewakuacja, utrata ciągłości operacyjnej i chaos logistyczny.

g) Atak na Protokoły Organizacyjne (Policy Subversion)

AI analizuje dostępne polityki IRP/BCP (Business Continuity Plans) i tworzy sytuację awaryjną, która celowo wyprowadza organizację poza granice własnej procedury.

Celem ataku jest zmuszenie ludzi do "improwizacji", czyli działania poza ramami zgodności.

Atak ten wywołuje sekwencję zdarzeń, której nie przewidziano w planie ciągłości działania (np. równoczesny incydent fizyczny i cybernetyczny). Zespół nie wie, według którego protokołu działać i popełnia błąd, a AI przewiduje ten błąd i go eskaluje.

W efekcie organizacja działa "poza planem" i jest podatna na dalsze ataki, dezinformację, kompromitację.

h) Atak przez Zatrucie Danych (Data Poisoning Infrastructure)

Napastnik nie atakuje systemów bezpośrednio, lecz modyfikuje dostępne dane (np. publicznie), które są wykorzystywane do trenowania AI w systemach predykcyjnych zarządzających infrastrukturą (np. pogodą, logistyką, energią).

Celem ataku jest zanieczyszczenie modeli predykcyjnych, aby podejmowały błędne decyzje w przyszłości.

Działa to w taki sposób, że:

- Fałszywe dane o trendach pogodowych, popycie energetycznym, wzorcach transportowych są publikowane w otwartych źródłach (np. Open Data, publiczne API),

- Modele AI odpowiedzialne za zarządzanie infrastrukturą uczą się na tych danych (np. przewidują szczyt energetyczny tam, gdzie go nie będzie),

- Podejmują decyzje w oparciu o toksyczne dane.

W efekcie nastepuje np. zaburzenie dostaw, złe alokacje zasobów, realne awarie wynikające z fałszywej prognozy.

|

⸻ Odporność systemu to nie tylko firewalle ⸻ AI jako broń strategicznaNie jesteśmy atakowani technicznie – jesteśmy mapowani, modelowani, antycypowani. AI już tu jest. I uczy się szybciej, niż jesteśmy w stanie przewidzieć konsekwencje. Potrzebna jest zmiana paradygmatu od "reagowania" do predykcyjnej odporności. |

Mapa wektorów ataku AI

5. Nowa epistemologia bezpieczeństwa, czyli jak myśleć o IK w czasach AI

W czasach, gdy sztuczna inteligencja potrafi rekonstruować logikę działania systemu na podstawie otwartych danych, dotychczasowe założenia bezpieczeństwa przestają wystarczać.

- Każdy dokument bezpieczeństwa to nie tylko zabezpieczenie – to potencjalna mapa dla przeciwnika.

- Każdy system wykorzystujący AI może stać się bronią, jeśli jego logika działania zostanie odczytana.

- Każda infrastruktura to zestaw modeli i sekwencji – a te można złamać analizą, nie koniecznie włamaniem.

|

Redefinicja Bezpieczeństwa AI nie musi się włamać. Wystarczy, że ją nauczysz, jak działasz. Nie chroni nas to, co zainstalowaliśmy. Chroni nas to, co potrafimy przewidzieć i zrozumieć. AI nie potrzebuje backdoora. Wystarczy, że zna nasze procedury, nasze terminy, nasze łatki i nasze błędy poznawcze. |

Bezpieczeństwo w erze AI to nie kwestia "czy coś wycieknie" – ale czy rozumiemy, czego AI może się z tego nauczyć, a współczesna ochrona nie polega już na wzmacnianiu murów, ale na przewidywaniu sposobu, w jaki algorytm odtworzy nasz sposób działania.

|

Myślenie predykcyjne – najcenniejsza umiejętność nowego bezpieczeństwa Czym jest myślenie predykcyjne... ⸻ Nie odpowiada na pytanie: "co było?", lecz: "co może się zdarzyć, zanim będzie za późno?" |

W epoce, gdy dane są paliwem dla AI, a atak może polegać na manipulacji informacją, kluczowa staje się nie tylko ochrona, ale zdolność do przewidywania. Myślenie predykcyjne to nie science-fiction, tylko fundament odporności poznawczej. To sposób analizowania rzeczywistości, który nie opiera się wyłącznie na tym, co już się wydarzyło (reakcja), lecz koncentruje się na tym, co może się wydarzyć – zanim nastąpi. To forma świadomego przewidywania przyszłych stanów systemu, zachowań ludzi, reakcji przeciwnika, na podstawie danych, wzorców, kontekstu i zależności, których inni jeszcze nie dostrzegli.

|

Atak nie musi być techniczny – może być poznawczy. |

6. Zmiana paradygmatu bezpieczeństwa, czyli co naprawdę należy zacząć robić

Dotychczasowe strategie ochronne zakładały, że atak trzeba odeprzeć. W rzeczywistości algorytmy już są w środku – analizują, przewidują, modelują reakcje. Dlatego konieczne staje się przejście od reakcji do redefinicji – nie narzędzi, lecz percepcji i logiki operacyjnej.

a) Dezinformacja jako tarcza

Celowe, rotacyjne zniekształcanie danych publicznych o strukturze infrastruktury (np. topology fuzzing) utrudnia AI tworzenie precyzyjnych modeli organizacyjnych i zależności. To działanie ofensywne w obronie – nie chodzi o ukrycie wszystkiego, ale o dostarczenie danych, które prowadzą przeciwnika w ślepe uliczki. System nie musi być niewidzialny. Wystarczy, że będzie logicznie nieczytelny.

b) AI przeciwko AI

Tworzenie własnych modeli predykcyjnych opartych na AI, które testują odporność systemów zanim zrobi to przeciwnik.

To nie audyt – to walka symetryczna w cyberprzestrzeni. Red teaming nie może już być ludzki – musi być maszynowy.

Tylko AI jest w stanie wykryć luki, które inna AI mogłaby wykorzystać. Kto pierwszy nauczy się testować siebie samym językiem, jakim mówi agresor – ten wygra czas.

c) Testy odporności poznawczej

Nie wystarczy testować systemów. Trzeba testować ludzi – pod kątem dezinformacji, chaosu, przeciążenia poznawczego.

Symulacje incydentów muszą uwzględniać błędne alerty, sprzeczne dane, celową konfuzję — bo właśnie tak działa AI nastawiona na destabilizację operacyjną. Zespół reagowania nie pada w wyniku ataku, ale pod ciężarem niepewności.

Zespół reagowania nie pada w wyniku ataku, ale pod ciężarem niepewności. To nie błąd techniczny – to wichrowatość socjotechniczna, czyli stan, w którym przeciążony poznawczo człowiek traci zdolność rozróżnienia informacji istotnej od generowanej w celu sabotażu. AI nie musi przekroczyć żadnej zapory – wystarczy, że przepali uwagę.

d) Ukrywanie i maskowanie metadanych

To nie dane są najcenniejsze – tylko wiedza o tym, jak dane są tworzone, przesyłane i przetwarzane. Metadane ujawniają rytm operacyjny, schematy komunikacji, kadencyjność decyzji. Dla AI to nie ozdobnik – to mapa organizacji. Należy ukryć, zaciemnić lub rotować ślady aktywności, bo to nie dokumentacja zdradza – tylko to, jak i kiedy powstała.

W erze, w której dane stają się bronią, ochroną musi być nie tylko infrastruktura – ale informacja o samej infrastrukturze.

Nowa obrona zaczyna się od zrozumienia, co AI może zrekonstruować – i jak temu zapobiec.

⸻

Myślenie o infrastrukturze krytycznej wymaga odejścia od modelu "murów i strażników". AI nie potrzebuje włamania – wystarczy, że zrozumie, jak działamy.

Tu nie chodzi o klasyczny atak typu DDoS. To atak na zdolność percepcji, reagowania i podejmowania decyzji – prowadzony poprzez dane, nie przez siłę.

Prawdziwe bezpieczeństwo zaczyna się w chwili, gdy rozumiemy, że każde działanie – od aktualizacji po publikację polityki – jest potencjalnym źródłem wiedzy dla systemu, który nie śpi, nie zapomina, nie ocenia. On analizuje. I czeka.

⸻

|

Podstawą skutecznej ochrony infrastruktury krytycznej nie powinno być już wyłącznie zabezpieczanie dostępu, lecz szacowanie tego, czego może nauczyć się o niej obca, niezależna maszyna AI – i w jaki sposób tę wiedzę może wykorzystać. |

Prawdziwe bezpieczeństwo zacznie się wtedy, gdy zdamy sobie sprawę, że każdy nasz dokument, alert, decyzja – to potencjalne źródło wiedzy dla systemu, który:

- nie śpi,

- nie zapomina,

- nie ocenia.

|

⸻ AI nie przyjdzie - Ono już tu jest ⸻ |

Czy zdążymy przed tymi, którzy nie muszą pytać o budżet?

Kto pierwszy zrozumie, jak naprawdę działa AI – struktury bezpieczeństwa publicznego czy te, które operują poza jego granicami?

To nie kwestia certyfikatów – ani systemowych, ani personalnych. Nie decyduje liczba wdrożeń, nie decyduje długość CV ani portfolio ukończonych szkoleń. Decyduje zdolność do myślenia predykcyjnego, nieliniowego, pozasystemowego.

Problem w tym, że takich ludzi nie przyciąga się etatem. Ich nie interesują procedury, tylko modele. I bardzo często – nie mieszczą się w budżetach bezpieczeństwa.

|

To właśnie myślenie predykcyjne odróżnia eksperta od administratora. Administrator patrzy w logi. Ekspert patrzy w modele, zanim logi coś pokażą. To także fundament nowej odporności infrastruktury krytycznej – nie tej opartej na liczbie firewalli, ale na umiejętności wyprzedzającej analizy "Co AI mogłaby zrobić z naszymi metadanymi, gdyby je zrekonstruowała?" |

W świecie, w którym przewagę daje umiejętność modelowania zachowań, wygra nie ten, kto lepiej reaguje, lecz ten, kto szybciej rozpozna wzorzec — i uderzy wyprzedzająco.

Pytanie nie brzmi już: "Czy uda się obronić infrastrukturę krytyczną".

Pytanie brzmi: "Czy zdołamy rozpoznać tych, którzy potrafią naprawdę ją chronić — zanim zatrudnią ich inni".

"W epoce sztucznej inteligencji, prawdziwą bronią jest przewidywanie – a ofiarą ludzka rutyna."

własny

Uwaga

Zamieszona treść ma wyłącznie charakter informacyjno-edukacyjny i nie może być wykorzystana w jakikolwiek sposób niezgodny z prawem. Przed zastosowaniem się m.in. do wskazówek i porad zawartych w artykule należy bezwzględnie skonsultować się z ekspertem i/lub skorzystać z usług prawnika. Informacje zawarte w niniejszym artykule zostały zebrane i przedstawione w dobrej wierze i na podstawie źródeł uznanych za wiarygodne, jednak autor nie ponosi odpowiedzialności za kompletność, aktualność oraz rzetelność zamieszczonych informacji, które mogą być przedstawione w formie niepełnej, skróconej lub mogą być przedawnione. Autor artykułu nie ponosi żadnych konsekwencji wynikających z wykorzystania informacji zawartych w niniejszym poście.

Źródło:

- Siddiqi, Murtaza Ahmed, Wooguil Pak, and Moquddam A. Siddiqi. 2022. A Study on the Psychology of Social Engineering-Based Cyberattacks and Existing Countermeasures. Applied Sciences 12(12).

- Langner, Ralph. 2011. Stuxnet: Dissecting a Cyberwarfare Weapon. IEEE Security and Privacy Magazine 9(3):49-51.

- Francia, Jerson, Derek Hansen, Ben Schooley, Matthew Taylor, Shydra Murray, and Greg Snow. 2024. Assessing AI vs Human-Authored Spear Phishing SMS Attacks: An Empirical Study.” arXiv preprint arXiv:2406.13049.

- Cherepanov, Anton, and Robert Lipovsky. 2017. Industroyer: Biggest Threat to Industrial Control Systems Since Stuxnet. ESET Research.

- Cybersecurity and Infrastructure Security Agency (CISA). 2021. Alert (AA21-131A): DarkSide Ransomware: Best Practices for Preventing Business Disruption from Ransomware Attacks.

- Cybersecurity and Infrastructure Security Agency (CISA). 2021. Alert (AA20-352A): Advanced Persistent Threat Compromise of Government Agencies, Critical Infrastructure, and Private Sector Organizations.

- National Audit Office (NAO). 2017. Investigation: WannaCry cyber attack and the NHS.

- Olabiyi, Winner. 2023. Combating Alert Fatigue: AI-Enhanced SIEM Framework for Optimized Incident Response. April. Ladoke Akintola University of Technology.

- Red Teaming LLMs: 8 Techniques and Mitigation Strategies.

- DARPA. 2016. “Cyber Grand Challenge Final Event.” https://www.darpa.mil/program/cyber-grand-challenge.

- Tidy, Joe. 2019. AI Used to Mimic CEO’s Voice in Scam. BBC News, August 30. https://www.bbc.com/news/technology-48908736.

- Lee, Robert M., Michael J. Assante, and Tim Conway. 2016. Analysis of the Cyber Attack on the Ukrainian Power Grid. SANS Industrial Control Systems. https://media.kasperskycontenthub.com/wp-content/uploads/sites/43/2016/05/20081514/E-ISAC_SANS_Ukraine_DUC_5.pdf.

- Rządowe Centrum Bezpieczeństwa (RCB). 2023. Narodowy Program Ochrony Infrastruktury Krytycznej. https://www.gov.pl/web/rcb/narodowy-program-ochrony-infrastruktury-krytycznej.

Przeczytaj również: Rodzaje zagrożeń dla Infrastruktury Krytycznej w erze cyfryzacji i AI, Pojęcie infrastruktury krytycznej, Infrastruktura krytyczna w teorii, Infrastruktura krytyczna w ujęciu prawnym, Właściwości systemu infrastruktury krytycznej, Architektura systemu infrastruktury krytycznej, Bezpieczeństwo energetyki jądrowej w Polsce, Cyberterroryzm jako element zagrożenia, Terroryzm a infrastruktura krytyczna, Uzależnienie od obcej technologii, Ochrona infrastruktury krytycznej, Środki ochrony infrastruktury krytycznej, Zabezpieczenia infrastruktury krytycznej, Rozpoznanie i wyznaczenie infrastruktury krytycznej, Zarządzanie infrastrukturą krytyczną, Zarządzanie ryzykiem w infrastrukturze krytycznej, Planowanie zarządzania ryzykiem, Identyfikacja ryzyka, Jakościowa i ilościowa analiza ryzyka, Planowanie reakcji na ryzyko, Monitorowanie ryzyka, Literatura dot. infrastruktury krytycznej, Akty prawne dot. infrastruktury krytycznej

Publikacja jest dostępna na licencji Creative Commons Uznanie autorstwa 4.0 Międzynarodowe, pewne prawa zastrzeżone na rzecz autora i machnacz.eu. Zezwala się na dowolne wykorzystywanie treści publikacji pod warunkiem wskazania autora (Andrzej Machnacz, machnacz.eu) i podania informacji o licencji.