Modelowanie słabości systemowych jako klucz do zrozumienia nowoczesnych zagrożeń poznawczych i strukturalnych

W dobie operacji asynchronicznych i konfliktów poznawczych ochrona infrastruktury krytycznej nie może opierać się wyłącznie na zabezpieczeniach technicznych.

Dziś zagrożeniem nie jest tylko to, co może zostać zaatakowane, ale to, co system może zrobić sam ze sobą, gdy zostanie poddany precyzyjnie zaprojektowanemu zakłóceniu.

|

Ochrona IK wymaga nie tylko zabezpieczeń, ale także zrozumienia logiki jej możliwego rozpadu. |

Poniższa analiza to propozycja nowej doktryny ochrony infrastruktury: nie przez twardość, ale przez zrozumienie jej wewnętrznej logiki.

Modelowanie odwrotne, teoria grafów decyzyjnych i matematyka operacyjna — to dziś narzędzia, które rozróżniają instytucję bezpieczną od podatnej na sabotaż poznawczy. Przedstawiony model myślenia stanowi próbę redefinicji bezpieczeństwa — nie jako ochrony przed atakiem, ale jako zdolności przewidzenia własnego rozpadu.

1. Infrastruktura jako graf decyzyjny

Każda organizacja, niezależnie od tego, czy mówimy o wojsku, administracji czy kluczowym podmiocie sektora ochrony zdrowia, może zostać zredukowana do struktury grafowej. W ujęciu decyzyjno-operacyjnym model taki przyjmuje postać skierowanego grafu G = (V, E), gdzie:

- V (vertices) to zbiór węzłów reprezentujących elementy funkcjonalne: jednostki, procesy, systemy, ludzi,

- E (edges) to krawędzie obrazujące zależności: przepływ informacji, zależności operacyjne i hierarchie decyzyjne.

Ten sposób modelowania pozwala traktować organizację nie jako sztywną strukturę, ale jako dynamiczną sieć podatności, w której:

- można precyzyjnie wskazać najkrótsze ścieżki propagacji decyzji i informacji (np. algorytm Dijkstry),

- zidentyfikować węzły o największej centralności (closeness, betweenness), będące potencjalnymi punktami krytycznymi,

- wyznaczyć minimalne cięcia (min-cut), których naruszenie może rozdzielić system na niekomunikujące się segmenty,

- oraz zbudować zestawy dominujące, czyli minimalne podzbiory, które mogą wpłynąć lub przejąć kontrolę nad resztą systemu.

W praktyce pozwala to nie tylko na symulację propagacji zakłóceń, ale również na:

- analizę efektywności ścieżek decyzyjnych (czy nie są zbyt scentralizowane),

- projektowanie redundancji (np. przez alternatywne połączenia między kluczowymi węzłami),

- oraz wykrywanie strukturalnych słabości, które — przy odpowiednio zaplanowanym zakłóceniu — mogą wywołać efekt domina o charakterze systemowym.

|

Analiza strategiczna to sztuka rozpoznania, które węzły decyzyjne naprawdę sterują systemem. Predykcyjna – to zdolność przewidzenia, jak ich zakłócenie rozłoży całość. |

Wystarczy jeden punkt węzłowy "o właściwej centralności", aby sparaliżować kilkustopniową reakcję organizacyjną. Dlatego graf decyzyjny to nie tylko metafora, ale konkretne narzędzie analizy strategicznej i predykcyjnej.

2. Infrastruktura jako graf decyzyjny

Jeśli organizację da się opisać jako graf decyzyjny, to jej dezintegracja może być potraktowana jako zadanie optymalizacyjne w przestrzeni strukturalnej. Innymi słowy — atak na infrastrukturę nie musi być fizyczny, ani nawet techniczny. Wystarczy go dobrze policzyć.

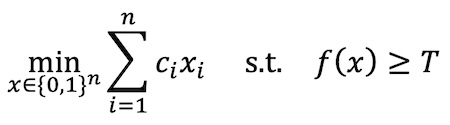

Taki atak może być sformułowany jako problem dyskretnej optymalizacji nad grafem G:

Gdzie:

- xi = 1 oznacza aktywację ataku na węzeł i (np. poprzez zakłócenie, dezinformację, przejęcie kanału),

- ci to koszt lub trudność zakłócenia danego elementu,

- f(x) to funkcja oceniająca stopień dysfunkcji całego systemu (np. liczba zerwanych kanałów decyzyjnych),

- T to próg, po przekroczeniu którego system traci spójność operacyjną.

|

Interpretacja wzoru:

|

To już nie jest klasyczna analiza ryzyka, lecz modelowanie strukturalnego sabotażu — w którym najgroźniejszy wariant nie zaczyna się od pytania "gdzie zaatakować?", ale od "jaki efekt chcemy osiągnąć?".

W tym miejscu pojawia się modelowanie odwrotne (inverse optimization) — podejście, w którym obserwując reakcje systemu, próbujemy odtworzyć jego wewnętrzną logikę decyzyjną. Dla człowieka to zaawansowana analiza sieciowa. Dla AI? To statystyczna rekonstrukcja funkcji celu i ograniczeń – swoiste "odczytanie duszy" organizacji na podstawie jej zachowań.

|

Atak "od skutku do przyczyny" – tak właśnie wygląda nowa epoka wojny poznawczej. |

W efekcie przeciwnik może nie tylko zaplanować atak, ale też zasymulować reakcję systemu i wybrać scenariusz, który osiągnie maksymalny efekt przy minimalnym nakładzie.

Przykład operacyjny – atak na system dowodzenia logistycznego

Można sobie wyobrazić strukturalnie zależną organizację, np. system dowodzenia logistyką wojskową w czasie operacji ekspedycyjnej. Główne węzły to:

- centrum planowania logistyki (CPLog),

- moduł zarządzania zapasami (SupplyOps),

- zespół transportu strategicznego (StratTrans),

- interfejs komunikacji z polami operacyjnymi (OpLink).

Zakłada się, że cały system może być opisany jako graf zależności G = (V,E) z ustaloną wagą dla każdego węzła (wg wpływu na całość operacji).

Atakujący nie przeprowadza cyberataku. Zamiast tego rozpuszcza dezinformację sugerującą, że dane z SupplyOps są błędne, jednocześnie wysyła zakłócone komunikaty przez OpLink, wpływające na interpretację sygnałów z frontu.

W modelu optymalizacji:

- x2 = 1: atak na SupplyOps przez dezinformację logistyczną,

- x4 = 1: atak na OpLink przez zakłócenie kanału komunikacji,

- c2 = 2, c4 = 1: koszt ataku niski, bo nie trzeba przejmować systemów – wystarczy je tylko zdestabilizować poznawczo,

- f(x) = 0.7: funkcja dysfunkcji osiąga 70%, bo CPLog traci wiarygodność danych i wstrzymuje działania, StratTrans nie podejmuje decyzji transportowych.

Po przekroczeniu progu T = 0.6, system zachowuje się jak sparaliżowany, mimo że wszystkie serwery działają, ludzie są na stanowiskach, a żadna infrastruktura fizyczna nie została naruszona.

To właśnie sabotaż strukturalny przez modelowanie poznawcze — optymalizacja nie idzie po kablach, tylko po decyzjach.

W modelu odwrotnym, AI – analizując czasy reakcji i schematy komunikacji – mogłaby zidentyfikować SupplyOps jako węzeł dominujący, a OpLink jako punkt wrażliwy na zewnętrzną ingerencję. To nie analiza bezpieczeństwa IT – to modelowanie odporności systemu decyzji jako układu matematycznego.

3. Infrastruktura jako graf decyzyjny

Z perspektywy atakującego najcenniejszym scenariuszem nie jest frontalne uderzenie, lecz minimalna ingerencja, która uruchamia reakcję łańcuchową — efekt kaskady, który sam się niesie przez kolejne warstwy organizacji.

Jeśli organizacja funkcjonuje jak sieć decyzyjna, to sabotaż można potraktować jak proces propagacji na grafie: wystarczy aktywować jeden punkt, by zaburzenie przeszło przez strukturę jak impuls przez układ neuronowy — omijając zabezpieczenia, bo bazuje nie na technologii, lecz na logice działania.

Modelowanie takiej propagacji może przyjąć różne formalizmy:

- modele dyfuzji (diffusion models) — wzorce rozpływu zakłócenia przez sieć zależności,

- symulacje Monte Carlo — ocena statystycznych skutków zakłóceń przy zmiennych warunkach wejściowych,

- modele stochastyczne z opóźnieniem czasowym — odwzorowanie reakcji systemu w czasie, z uwzględnieniem inercji decyzyjnej i efektu opóźnionych rozkazów.

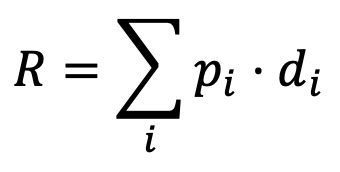

Kluczowe jest jednak to, że każda taka symulacja może być oceniona nie tylko przez pryzmat prawdopodobieństwa, ale przez funkcję ryzyka (model bazowy/uproszczony):

Gdzie:

- pi to prawdopodobieństwo zakłócenia węzła i z uwzględnieniem jego podatności operacyjnej,

- di to jego krytyczność — obiektywnie mierzona np. przez centralność sieciową, poziom odpowiedzialności lub liczbę zależnych od niego procesów.

⸻

Powyższy wzór wyliczenia ryzyka ma charakter uproszczony i służy przede wszystkim jako ilustracja zasady — pokazując, że ryzyko strukturalne wynika nie tylko z prawdopodobieństwa zakłócenia, ale także z funkcjonalnej wagi węzłów w sieci decyzyjnej.

W zastosowaniach operacyjnych lub eksperckich, zwłaszcza przy modelowaniu efektów propagacji i reakcji systemu w czasie, stosuje się bardziej złożone modele. Ich dobór i konstrukcja powinny być zawsze dostosowane do konkretnej topologii organizacyjnej i dynamiki działania systemu.

⸻

Rozszerzone modele wyliczania ryzyka dezintegracji strukturalnej

Wyliczenie ryzyka w kontekście dezintegracji strukturalnej nie może opierać się wyłącznie na prostych miarach punktowych. W rzeczywistości systemów decyzyjnych kluczowe jest to, jak zaburzenie się propaguje i kiedy system traci zdolność reakcji. Dlatego oprócz modelu bazowego, warto wprowadzić warianty rozszerzone — uwzględniające zależności między węzłami oraz dynamikę czasową. To nie są wzory akademickie, ale narzędzia poznawcze, które pozwalają zobaczyć, gdzie system sam doprowadzi się do stanu krytycznego.

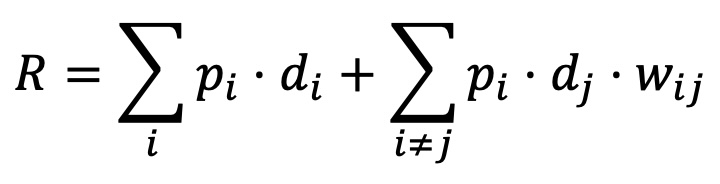

Model ryzyka z propagacją zaburzeń między węzłami

Poniższa formuła rozszerza klasyczne wyliczenie ryzyka o efekt propagacji — zakładając, że zakłócenie w jednym węźle może wpłynąć na inne elementy systemu, nawet jeśli nie zostały one bezpośrednio zaatakowane. Drugi składnik sumy opisuje wpływ węzła i na zakłócenie w węźle j, ważony przez siłę zależności między nimi wij. Taki model pozwala uchwycić systemową wrażliwość na kaskadowe reakcje – co ma kluczowe znaczenie przy analizie struktur, w których decyzje są współzależne.

Gdzie:

• wij – waga propagacji zakłócenia z węzła i do j (np. zależność decyzyjna, operacyjna lub informacyjna).

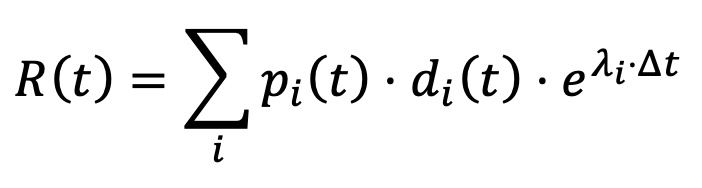

Model ryzyka z funkcją czasu i inercji reakcji

Ten wariant modelu uwzględnia wpływ czasu na narastanie ryzyka w systemie decyzyjnym. Współczynnik 入i opisuje tempo eskalacji skutków zakłócenia, a Δt odpowiada za opóźnienie reakcji organizacji. Zmienność parametrów pi(t), di(t) w czasie oddaje dynamikę zarówno ryzyka, jak i krytyczności elementów w różnych fazach działania systemu. Tego typu ujęcie jest szczególnie istotne w strukturach, gdzie czas reakcji ma decydujący wpływ na skutki operacyjne – np. w logistyce, energetyce czy dowodzeniu.

Gdzie:

- 入i – współczynnik eskalacji zaburzenia w węźle i,

- Δt – czas opóźnienia reakcji systemu (odzwierciedlający inercję decyzyjną),

- pi(t), di(t) – prawdopodobieństwo zakłócenia i jego krytyczność jako funkcje czasu (zmienne dynamiczne w trakcie propagacji zaburzenia).

Zaproponowane formuły wyliczenia ryzyka nie służą do opisu przeszłości, lecz do przewidywania katastrofy zanim się zacznie. Gdy system przestaje być liniowy, a decyzje zależą od wcześniejszych błędów i opóźnień, klasyczne ryzyko staje się ślepe. W takich warunkach nie liczy się już punkt początkowy, lecz trajektoria zaburzenia.

|

System nie musi upaść, by został unieszkodliwiony — wystarczy, że przestanie działać zgodnie z własną logiką. |

To nie jest już tylko teoria, tylko symulowana dezintegracja — narzędzie ofensywne i defensywne zarazem. Atakujący może obliczyć, który węzeł opłaca się zniszczyć. A broniący — jeśli wie, że tak właśnie działa przeciwnik — może system przeorganizować tak, by żaden pojedynczy punkt nie był warty aż tyle.

Przykład operacyjny – sabotaż predykcyjny w infrastrukturze energetycznej

W systemach energetycznych sabotaż nie musi oznaczać ciemności. Wystarczy, że pojawi się światło… nie tam, gdzie trzeba.

Rozważmy regionalny system dystrybucji energii elektrycznej, składający się z:

- centrum zarządzania SCADA (Supervisory Control and Data Acquisition), które podejmuje decyzje na podstawie danych w czasie rzeczywistym,

- punktów pomiarowych napięć i mocy PMU (Phasor Measurement Units) – odpowiedzialnych za pomiar synchroniczny w sieci przesyłowej,

- lokalnych centrów dystrybucyjnych LDC (Local Distribution Centers) – reagujących automatycznie na zmiany parametrów,

- oraz łączności z systemem zarządzania kryzysowego CEM (Crisis/Emergency Management).

Atak nie polega na przejęciu systemu, lecz na subtelnej modyfikacji danych wejściowych: nieznacznych, ale skoordynowanych fluktuacjach czasowych w odczytach PMU. SCADA, opierając się na przesuniętym obrazie stanu sieci, podejmuje decyzje korekcyjne, które pozornie działają poprawnie – ale w praktyce przekierowują nadmiar mocy w stronę regionu już przeciążonego.

Z punktu widzenia operatora wszystko działa. Z punktu widzenia rzeczywistości – właśnie rozpoczął się dryf napięciowy, który może skończyć się samospaleniem transformatora lub selektywnym wyłączeniem obszaru.

Model strukturalny tego sabotażu:

- x1 = 1: zakłócenie punktu pomiarowego PMU (fałszywe dane amplitudy napięcia),

- x3 = 1: manipulacja czasem reakcji LDC (wprowadzenie opóźnień),

- c1 = 1, c3 = 2: niskokosztowe ingerencje, nie wymagające dostępu do SCADA,

- f(x) = 0.75: system traci 75% precyzji predykcji, a reakcje automatyczne stają się chaotyczne.

To nie jest cyberatak, tylko symulowany błąd przewidywania, w którym przeciwnik nie włamuje się do systemu — tylko wprowadza go w błąd dokładnie tak, jak SCADA została nauczona reagować.

|

Model decyzyjny infrastruktury krytycznej musi być testowany nie tylko pod kątem cyberodporności, ale pod kątem odporności na własne mechanizmy korekcyjne. System, który "sam się oszukuje", jest podatniejszy niż system zaatakowany. |

Bo w wojnie predykcyjnej nie chodzi o to, by coś zniszczyć. Wystarczy, by system sam podjął decyzję, która go rozłoży — logicznie, zgodnie z procedurą, i bez udziału człowieka. Najlepszy atak to taki, który działa jak rekomendacja, a nie sabotaż.

4. Obrona przez modelowanie predykcyjne

Ta sama matematyka, która może posłużyć do zaplanowania sabotażu, może zostać użyta do czegoś znacznie cenniejszego — uprzedzania go. Warunek jest jeden: trzeba przestać traktować własną strukturę jak coś trwałego i niezniszczalnego, a zacząć ją widzieć jako model do testowania. Do atakowania. Do kontrolowanej dezintegracji.

Symulowany atak na własną organizację nie jest przejawem paranoi — jest koniecznością operacyjną. To dzięki niemu można:

- wykryć punkty krytyczne, zanim zrobi to przeciwnik,

- przetestować scenariusze awarii w warunkach zmienności i opóźnienia,

- przearanżować topologię decyzyjną tak, by zwiększyć odporność na zaburzenia strukturalne.

To nie teoria zarządzania kryzysowego, tylko symulacyjna inżynieria odporności.

W praktyce wykorzystuje się tu:

- Red Teaming z użyciem algorytmów genetycznych — czyli automatyczne wyszukiwanie najsłabszych punktów przez cyfrowego przeciwnika, który mutuje swoje strategie, ucząc się systemu jak napastnik klasy APT;

- analizę sieci dynamicznych (temporal networks) — gdzie centralność i zależności zmieniają się w czasie, a nie są statycznym schematem z dokumentu ISO;

- teorię gier z przeciwnikiem o niepełnej informacji — modelując nie tylko atak, ale też niepewność jego percepcji, intencji i możliwości, co lepiej oddaje rzeczywistość walki informacyjnej i dezinformacyjnej.

|

Tylko organizacja, która potrafi przewidzieć swoją śmierć, ma prawo planować dalsze życie. |

Obrona zaczyna się tam, gdzie kończy się komfort — czyli w momencie, w którym świadomie modelujemy własną podatność na porażkę.

5. Adaptacja struktury jako tarcza

W świecie, w którym przeciwnik modeluje naszą organizację szybciej, niż my sami potrafimy ją zrozumieć, sztywność jest zaproszeniem do ataku. Tymczasem najlepszą formą ochrony może być… brak stałej formy.

Zmienność organizacyjna — traktowana dotąd jako wada systemu — staje się dziś świadomą strategią obronną. Jeśli system nie daje się jednoznacznie zmapować, staje się trudniejszy do złamania. W logice ofensywnej to problem. W logice odporności — zasób.

Dlatego pojawiają się nowe koncepcje strukturalnej adaptacji:

- Organizacja mimetyczna — system, który nie ma jednej twarzy. Zmienia układ zależności, priorytetów, przepływów informacji. Przeciwnik widzi co innego niż to, co faktycznie działa. Trochę jak mimetyczny organizm — przystosowuje się nie przez siłę, lecz przez zmianę powierzchni, rytmu i wzorca.

- Zarządzanie oparte na fluktuacji — zamiast centralnej kontroli: zespoły decyzyjne zdolne do rotacji i adaptacji, których skład, procedury i dostęp do informacji zmieniają się w czasie. Dla wewnętrznej operacyjności — wyzwanie. Dla zewnętrznego przeciwnika — nieciągłość, chaos, nieprzewidywalność.

- Obrona przez entropię poznawczą — jeśli system zmienia się szybciej, niż da się go zmapować, to wszelka predykcja staje się nieskuteczna. To nie obrona przez siłę, lecz przez tempo zmienności, które przekracza zdolność wnioskowania przeciwnika.

Tego typu podejście można nazwać reorganizacją odpornościową — celowym przeprojektowaniem struktury nie po to, by działała szybciej, ale by trudniej było ją przewidzieć, sklasyfikować lub zaatakować modelem.

|

Nieprzewidywalność to nowa odporność, bo system, którego nie da się zrozumieć, nie da się też złamać. Każdy system, który zbyt długo pozostaje sobą, staje się przewidywalny, a przewidywalność to luksus, na który dziś nie stać nawet armii. Zmieniaj się szybciej, niż przeciwnik zdąży Cię zrozumieć. |

Nie chodzi o to, by chaos zastąpił porządek. Chodzi o to, by porządek nie był jednowymiarowy i przewidywalny. System, który myśli o sobie jako o organizmie zdolnym do przystosowania, zaczyna budować odporność nie przez kontrolę, lecz przez transformację.

6. Wnioski dla struktur wojskowych i strategicznych

Współczesne pole walki nie zaczyna się już od wystrzału. Zaczyna się od analizy — topologii decyzyjnej, podatności organizacyjnej, przepływów informacyjnych. Kto nie zna własnej struktury, ten gra w grę, której zasad nie rozumie. A w świecie symulowanej dezintegracji przegrywa nie ten, kto został trafiony, ale ten, którego model można było wcześniej przewidzieć.

Dlatego każda struktura o znaczeniu strategicznym powinna:

- posiadać formalny model swojej topologii decyzyjnej — nie jako diagram PowerPointa, ale jako realny graf zależności, z wagami, przepływami i punktami krytycznymi;

- regularnie przeprowadzać symulowane ataki optymalizacyjne — by wiedzieć, ile kosztuje zniszczenie systemu od środka i które punkty warto chronić naprawdę;

- projektować organizację z myślą o analizie odwrotnej — skoro przeciwnik rekonstruuje nasze cele na podstawie zachowania, trzeba planować jak aktor w teatrze wojny — z warstwą pozoru i mylącej trajektorii;

- integrować badania operacyjne z AI do modelowania przeciwnika — nie jako ćwiczenie laboratoryjne, ale jako ciągłą rekonstrukcję umysłu napastnika, zanim ten zdąży zaatakować.

|

Przyszłość obrony nie leży w technologii, lecz w umiejętności przewidzenia własnej dezintegracji zanim zrobi to wróg. |

Bo nowoczesna wojna nie toczy się już tylko w cyberprzestrzeni. Toczy się w logice organizacji, a w epoce asymetrii poznawczej wygrywa nie ten, kto ma więcej broni, ale ten, kto lepiej rozumie własną złożoność — szybciej niż zrobi to przeciwnik.

To nie kwestia nowej technologii, ale nowego sposobu myślenia, bo systemów nie chroni się już przez silniejsze zapory, ale przez lepsze zrozumienie, jak i dlaczego mogą się rozpaść. Przyszłość planowania operacyjnego nie będzie należała do tych, którzy będą mieli więcej danych, ale będzie należała do tych, którzy potrafią stworzyć modele porażki szybciej, niż przeciwnik zdąży zbudować model ataku.

Jednostka, instytucja czy system dowodzenia, który nie zna własnych słabych punktów, nie przetrwa w świecie, w którym wojna toczy się przez modelowanie i optymalizację decyzji.

Być może nadszedł czas, by zrewidować nawet najbardziej oczywiste praktyki informacyjne. Strony internetowe, dokumenty polityki otwartości, repozytoria PDF-ów z organizacją instytucji — to dziś nie są narzędzia transparentności, ale dane treningowe dla przeciwnika.

|

W dobie, gdy AI uczy się organizacji szybciej niż ich analitycy wewnętrzni, samo istnienie publicznych struktur informacyjnych (np. schematy działania, zakładki "o nas", procedury, zakresy odpowiedzialności, numery kontaktowe, repozytoria PDF-ów) staje się paliwem dla modelowania odwrotnego. |

Sztuczna inteligencja nie potrzebuje tajnych danych. Wystarczy jej struktura powierzchniowa — to, co jawne, otwarte, pozornie niegroźne. Na tej podstawie potrafi odtworzyć logikę całego systemu. Dlatego być może nadszedł czas, by państwowe instytucje przestały ujawniać swoją organizacyjną architekturę światu, który potrafi ją dziś zrekonstruować szybciej niż sami analitycy.

|

Nie wystarczy już chronić tajemnice. Trzeba przestać ujawniać to, co pozwala AI je przewidzieć. |

W epoce modelowania predykcyjnego, milczenie to nie tylko złoto. To bezpieczeństwo, bo w erze wojny predykcyjnej wygrywa nie ten, kto ma władzę — tylko ten, kto potrafi zniknąć z mapy poznawczej przeciwnika, a zwycięstwo zaczyna się dziś od tego, co zdecydujesz się przemilczeć.

"Nie musisz znać całej przyszłości. Wystarczy, że zrozumiesz własny koniec — zanim zrobi to wróg."

własny

|

⸻ Definicje kluczowych pojęć operacyjnych ⸻ Wojna poznawcza (Cognitive warfare) Forma konfliktu, której celem nie jest fizyczne zniszczenie, lecz przejęcie kontroli nad decyzjami, percepcją i logiką działania przeciwnika — poprzez ingerencję w informacje, procedury, systemy reagowania i mechanizmy poznawcze organizacji. Wojna poznawcza wykorzystuje modele systemowe, dane strukturalne i przewidywanie reakcji, by doprowadzić przeciwnika do autodestrukcyjnych działań przy zachowaniu pozorów autonomii decyzyjnej. Sabotaż poznawczy (Cognitive sabotage) Sabotaż strukturalny (Structural sabotage) Celowe działanie zakłócające spójność operacyjną organizacji poprzez ingerencję w jej zależności funkcjonalne, bez potrzeby niszczenia zasobów technicznych. Może przybrać formę dezorganizacji przepływów, dezaktywacji węzłów dominujących lub wymuszenia konfliktu proceduralnego. Modelowanie odwrotne (Inverse optimization/modeling) Modelowanie predykcyjne (Predictive modeling) Proces tworzenia formalnego modelu systemu w celu przewidywania jego przyszłych reakcji na zaburzenia, decyzje lub działania przeciwnika. W kontekście infrastruktury krytycznej modelowanie predykcyjne umożliwia symulację zachowań organizacji w sytuacjach kryzysowych, testowanie odporności decyzyjnej oraz identyfikację trajektorii, które prowadzą do punktów krytycznych lub autodezintegracji. Inercja decyzyjna (Decision inertia) Opóźnienie w reakcji systemu wynikające z jego wewnętrznych procedur, czasu przetwarzania informacji lub hierarchii zatwierdzania decyzji. Inercja decyzyjna zwiększa podatność systemu na zakłócenia stochastyczne i umożliwia atakującemu synchronizację zakłóceń z reakcją obronną – tak, by ta była spóźniona lub błędna. Trajektoria zaburzenia (Disruption trajectory) Dezintegracja strukturalna (Structural disintegration) System jako graf decyzyjny (Decision dependency graph) Topologia decyzyjna (Decision topology) Strukturalne odwzorowanie tego, jak podejmowane są decyzje w organizacji oraz w jaki sposób są one przekazywane i powiązane między elementami systemu. Obejmuje relacje hierarchiczne, operacyjne i informacyjne — wraz z ich kierunkiem, siłą i punktem inicjacji. Taka struktura umożliwia analizę odporności systemu na zakłócenia, identyfikację węzłów krytycznych oraz projektowanie reorganizacji zwiększających odporność na działania sabotażowe i poznawcze. Reorganizacja odpornościowa (Resilience-driven reorganization) Proces przeprojektowywania struktury organizacyjnej w celu zwiększenia jej odporności na analizę odwrotną, modelowanie predykcyjne i sabotaż strukturalny. W odróżnieniu od klasycznej reorganizacji zarządczej, ukierunkowanej na efektywność, reorganizacja odpornościowa ma na celu utrudnienie przewidywania reakcji systemu przez przeciwnika. |

Uwaga

Zamieszona treść ma wyłącznie charakter informacyjno-edukacyjny i nie może być wykorzystana w jakikolwiek sposób niezgodny z prawem. Przed zastosowaniem się m.in. do wskazówek i porad zawartych w artykule należy bezwzględnie skonsultować się z ekspertem i/lub skorzystać z usług prawnika. Informacje zawarte w niniejszym artykule zostały zebrane i przedstawione w dobrej wierze i na podstawie źródeł uznanych za wiarygodne, jednak autor nie ponosi odpowiedzialności za kompletność, aktualność oraz rzetelność zamieszczonych informacji, które mogą być przedstawione w formie niepełnej, skróconej lub mogą być przedawnione. Autor artykułu nie ponosi żadnych konsekwencji wynikających z wykorzystania informacji zawartych w niniejszym poście.

Źródło:

- Frączek, Marcin. 2022. Rozpoznanie wojskowe w kontekście walki informacyjnej. Przegląd Sił Zbrojnych 3: 8–15.

- Sowa, Bartosz J. 2023. Model wykorzystania zasobów osobowych Sił Zbrojnych RP w zarządzaniu kryzysowym. Rozprawa doktorska, Wojskowa Akademia Techniczna.

- Korpowski, Konrad. 2023. Operacje i siły specjalne w polityce bezpieczeństwa państwa w XXI wieku. Rozprawa doktorska, Uniwersytet Gdański.

- Mickiewicz, Piotr, i Daniel Damian Kasprzycki. 2021. Od ‘konfliktu hybrydowego’ do działań konwencjonalnych? Koncepcja oddziaływania militarnego Rosji po 2018 roku. Przegląd Bezpieczeństwa Wewnętrznego 25: 11–30.

- Gradzi, Dariusz. 2021. Najnowsze kierunki zmian regulacyjnych w zakresie walut wirtualnych z perspektywy przeciwdziałania praniu pieniędzy i finansowaniu terroryzmu. Przegląd Bezpieczeństwa Wewnętrznego 25: 31–58.

- Papayiannis, Georgios I. 2022. A Robust Decision Making Framework for Optimal Strategy Selection in Warfare under Model Uncertainty. arXiv preprint arXiv:2207.00861. https://arxiv.org/abs/2207.00861

- Ho, Edwin, Arvind Rajagopalan, Alex Skvortsov, Sanjeev Arulampalam, and Mahendra Piraveenan. 2021. Game Theory in Defence Applications: A Review. arXiv preprint arXiv:2111.01876. https://arxiv.org/abs/2111.01876

- Gibała, Mateusz. 2025. Rośnie zagrożenie sabotażu infrastruktury krytycznej w Europie. BiznesAlert.pl, January 17. https://biznesalert.pl/rosnie-zagrozenie-sabotazu-infrastruktury-krytycznej-w-europie/

Przeczytaj również: Między Kodem a Katastrofą - Nowe Paradygmaty Ataku na Infrastrukturę Krytyczną, Rodzaje zagrożeń dla Infrastruktury Krytycznej w erze cyfryzacji i AI, Pojęcie infrastruktury krytycznej, Infrastruktura krytyczna w teorii, Infrastruktura krytyczna w ujęciu prawnym, Właściwości systemu infrastruktury krytycznej, Architektura systemu infrastruktury krytycznej, Bezpieczeństwo energetyki jądrowej w Polsce, Cyberterroryzm jako element zagrożenia, Terroryzm a infrastruktura krytyczna, Uzależnienie od obcej technologii, Ochrona infrastruktury krytycznej, Środki ochrony infrastruktury krytycznej, Zabezpieczenia infrastruktury krytycznej, Rozpoznanie i wyznaczenie infrastruktury krytycznej, Zarządzanie infrastrukturą krytyczną, Zarządzanie ryzykiem w infrastrukturze krytycznej, Planowanie zarządzania ryzykiem, Identyfikacja ryzyka, Jakościowa i ilościowa analiza ryzyka, Planowanie reakcji na ryzyko, Monitorowanie ryzyka, Literatura dot. infrastruktury krytycznej, Akty prawne dot. infrastruktury krytycznej

Publikacja jest dostępna na licencji Creative Commons Uznanie autorstwa 4.0 Międzynarodowe, pewne prawa zastrzeżone na rzecz autora i machnacz.eu. Zezwala się na dowolne wykorzystywanie treści publikacji pod warunkiem wskazania autora (Andrzej Machnacz, machnacz.eu) i podania informacji o licencji.